ディープフェイクを見破るためにかかりすぎるコスト

2022年06月24日

20世紀初頭のこと。英イーストサセックスのピルトダウンにおいて、アマチュア考古学者のチャールズ・ドーソンがいくつかの化石人骨を発見した。彼は大英博物館のアーサー・スミス・ウッドワード卿と共に発掘・研究を続け、1912年、これらは新種の原始人類の化石で画期的な発見であるとして発表した。いわゆる「ピルトダウン人」である。

結論から言えば、このピルトダウン人は真っ赤な嘘で、数々の証拠も捏造されたものだった。人間やオラウータンの骨を加工し、さらに着色や摩耗といった処理をほどこすことで、それらしい「化石」を作り上げていたのだ。ピルトダウン人事件は研究不正の代表的な例、またもっとも大胆な例のひとつとして、現在でもよく知られている。

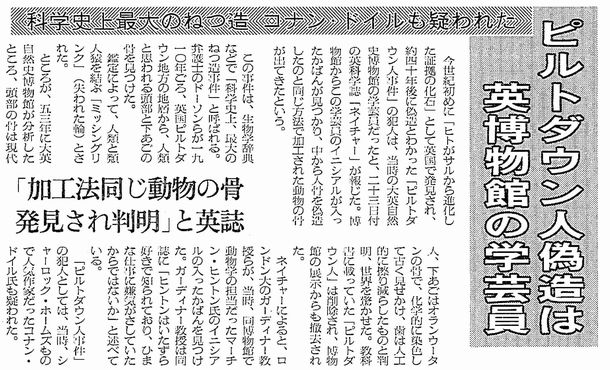

ピルトダウン人偽造をめぐる記事。1996年5月24付朝日新聞朝刊

ピルトダウン人偽造をめぐる記事。1996年5月24付朝日新聞朝刊しかしドーソンらの主張が明確に嘘と判定されるまで、発表から実に40年以上の月日が必要だった。1953年に行われた大英自然史博物館の分析によって、ようやく不正が立証されたのである。これには二度の世界大戦があるなどして、「証拠」を詳しく検証することが困難だったという背景もあるが、研究において証拠の捏造が行われた場合、それを否定することの難しさを示していると言えるだろう。

そしていま、研究における証拠の捏造がより加速しかねない事態が生まれている。それは思い通りのコンテンツを自在に生成できるAI(人工知能)の登場だ。

AIが自動でコンテンツ(画像や映像、音声など)を生成する。しかも実在の人物や景色などをそっくり真似ることもできる――そんなニュースは毎日のように流れてきて、もはや驚きではないという人も多いのではないだろうか。この論座でも、「実在するかのような人間の顔写真をAIで生み出し、それをプロフィールにしたSNSアカウントでロシア寄りの発言をさせる」という事例や、「AIを使って映像を生成し、オバマ元大統領に言っていないことを言わせる」などの事例を紹介してきた。

こうしたケースで主にAIが生み出してきたのは、(実在もしくは架空の)人間の顔や音声といったコンテンツだった。しかし当然の話だが、AIが生成できるテーマは人間だけではない。AIの開発方法次第で、どんなコンテンツでも簡単につくり出すことが可能な時代が到来しつつある。

たとえば米Googleは任意のテキスト(何らかの光景を描写するような文章)を与えると、そのテキストぴったりの画像を自動生成するAI「Imagen」を開発している。

実際の例を見てみよう。下の画像は、Googleがサンプルとして提供しているものだ。テキストは「タイムズスクエアで自転車に乗っているコーギー犬の写真。その犬はサングラスをかけてビーチハットをかぶっている」という意味の英文である。そしてその通りの画像を、AIは生成している。

与えられた任意のテキストぴったりの画像を自動生成する米GoogleのAI「Imagen」

与えられた任意のテキストぴったりの画像を自動生成する米GoogleのAI「Imagen」念のために言うが、この犬の画像は人間が制作したCGではない。コーギー犬やタイムズスクエアの画像を素材として与えたわけでもない。与えられたテキストのみから、AIが自動で生成したのである(そうしたAIを開発するには大量の画像データが「学習」用に与えられているので、その意味では参考になる画像を既に手にしていると表現できるかもしれないが)。

実はこうした「テキストから画像を生成するAI」はさまざまな企業が開発に取り組んでおり、GoogleはImagenがその中でも高い性能を実現していると自負している。それが正しい評価かどうかは専門家の意見を待つしかないが、優れた技術力を持つ企業が切磋琢磨することによって、AIの性能は急速に向上しているのである。

有料会員の方はログインページに進み、デジタル版のIDとパスワードでログインしてください

一部の記事は有料会員以外の方もログインせずに全文を閲覧できます。

ご利用方法はアーカイブトップでご確認ください

朝日新聞社の言論サイトRe:Ron(リロン)もご覧ください