2014年07月15日

――米大統領選とビッグデータ、あるいはマーケティングの手法を駆使した「マーケティング・デモクラシー」の問題を研究テーマに選ばれたのはどんな経緯からだったのですか。(聞き手は、松本一弥・『Journalism』編集長)

平林 実はアメリカ政治、特に大統領選に焦点を置くようになったのは、博士課程に進んでからなのです。アメリカにはそれまでも個人的な興味は持っていたのですが、本格的に研究留学をしたのは、共和党のジョージ・W・ブッシュと民主党のアル・ゴアが闘った2000年の大統領選挙の時でした。

平林紀子・埼玉大学教養学部教授

平林紀子・埼玉大学教養学部教授フルブライト客員研究員として都合1年半アメリカにいて、ハーバード大学とジョージ・ワシントン大学という二つの大学の大学院、アメリカ政治のオモテとウラを見るような職業大学院で研究をさせてもらったことが一番の転機になりました。

アメリカでは、選挙でマーケティングの手法を使うことは、プロフェッショナルとして政治にかかわる人々にとってはその当時からほぼ常識になっていました。特にジョージ・ワシントン大学の場合はそういうプロを養成する学校でもあるので、マーケティングと政治の問題を非常に身近に見る機会があったんです。

日本ではジャーナリズムを含め、「政治家のコミュニケーション」というと「メディア戦略」とか「広告」に関心が集中しますね。そうしたものは、マーケティング全体のプロセスの中では「風下」、最後の部分にあたりますが、でも「そのおおもとを見ないと本当のことはわからないな」と感じて研究を始めたのです。そしてその後も十数年間研究を続け、その成果を今回、『マーケティング・デモクラシー 世論と向き合う現代米国政治の戦略技術』という本にまとめたという形です。

――そもそも、米大統領選でビッグデータが活用されるようになったのはいつからなのでしょうか。

平林 「ビッグデータを選挙で使ったのはオバマ」といわれたりしますが、実際にはジョージ・W・ブッシュの時から始まりました。

00年の大統領選を制して第43代大統領になったブッシュが、02年の中間選挙でビッグデータのテストをした上で、04年の大統領選から本格的な活用を始めたという流れです。

その背景を少し説明しますと、00年の大統領選で、ブッシュとゴアが前代未聞の大接戦を闘ったことはみなさんまだご記憶だと思います。あの時、ブッシュはフロリダ州の投票を再集計した結果、かろうじて当選することができたのです。

具体的には全米得票率でゴアに47・9%対48・4%で負けていたのですが、大統領選は全米得票数ではなく州選挙人数の合計で決まるため、フロリダ州投票総数596万票のうち、わずかに537票差でフロリダ州を獲得したブッシュが、州選挙人数271人対266人の僅差でゴアを上回り、接戦を制しました。

この時、「これまでのやり方では有権者の動きをとらえきれていないのではないか?」という深刻な教訓が共和党にも民主党にも残りました。

実は00年の大統領選の直後に、共和党の中でも非常に有力な世論調査家と話をする機会があったのですが、彼も「今の課題は明確だ。有権者の母集団を考え直さなければならない」と指摘していました。「母集団を考え直す」とは、世論調査のサンプルのベースを変えるということです。そのためにはまず有権者のデータ収集からやり直さなければいけないと彼は話していました。

もともと、民主党支持者が主だった州はシンボルカラーのブルーから「ブルーステイト」、共和党支持者が主だった州は「レッドステイト」と呼ばれていますが、ブルーとレッドがはっきり分かれている州もあれば、モザイクのように混然一体と混じり合って遠くから見ると紫のように見える「パープルステイト」もあります。

ところがアメリカの場合、有権者の移転や新たな移民の流入によって、今まで共和党支持者が多かった州や地域で、潜在的な民主党支持層が増加したり、反対に民主党支持者の多い州や地域に共和党支持の人たちが移り住んだりする。このような選挙地図の変化の結果、共和党も民主党もそれまで持っていた有権者に関する情報が時代遅れになりつつあることが、00年の大統領選で明らかになったのです。

平林 そこでブッシュ陣営は04年の大統領選で、自分たちが保有していた有権者に関するデータに、消費者行動などのデータやその他のデータを加えてデータをマイニング(mining)したのが「ビッグデータ選挙」の最初となったわけです。

――「データをマイニングする」を日本語でいうとどうなりますか。

平林 「データ・マイニング」とは、多様なデータソースから集められた大量のデータの集積の中から、調査目的にとって意味がある、相関関係などの特定のパターンやルールを導き出す技法のことです。

例えば「ターゲットとなる有権者を判別するのに役立つ彼らの特性は何か」を知るには、政党が持っている献金者・支持者・活動家・運動員などのリストや世論調査結果、さらには個人の消費行動データなどをただ単に統合しただけでは使い物にならないのです。

そうした個人別の政治行動や消費行動のデータを加工して、例えば政党献金などの政治活動を統計的に予測する上で役に立つデータ、つまりは「使えるデータ」の形に変え、いろいろな統計解析手法を用いて知りたいグループの特性を明らかにするデータ処理技術と、それを活用するためのソフトウエアの開発が必要とされるわけです。

――ビッグデータを大統領選に採り入れたブッシュ陣営はどんな顔ぶれだったのですか。

平林 戦略担当のカール・ローブ、選対部長のジョー・オルボー、広報部長のカレン・ヒューズの3人が「鉄の三角形」を作っていました。

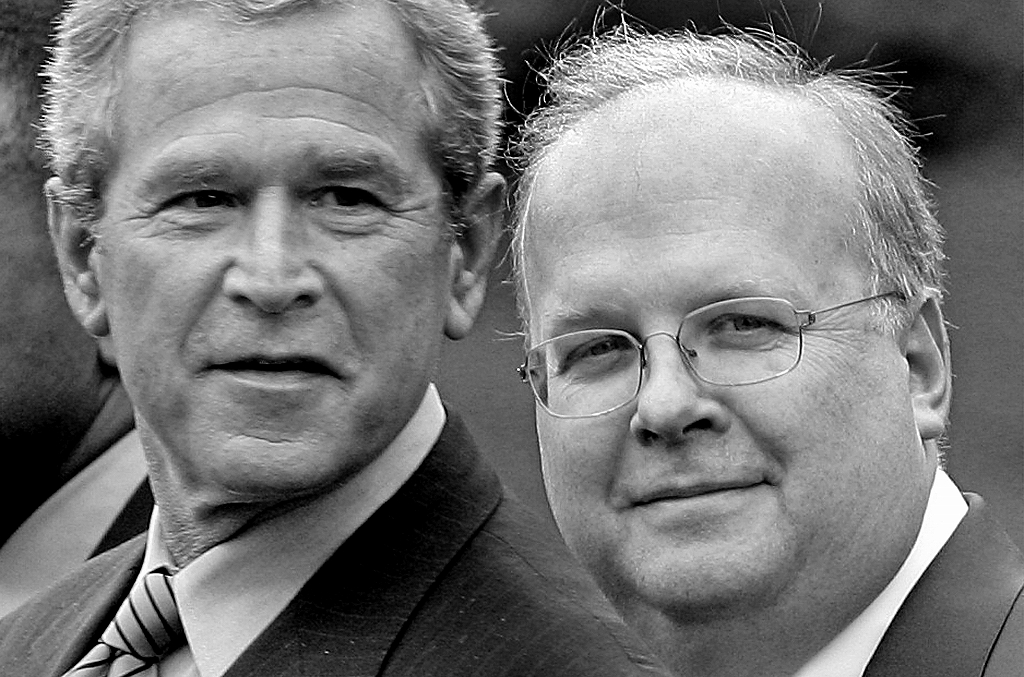

カール・ローブ氏(右)とブッシュ大統領=AP

カール・ローブ氏(右)とブッシュ大統領=APとりわけカール・ローブは「ブッシュの頭脳」と呼ばれた人で、勝つためには手段を選ばない人だったと思います。彼は戦略面では実力者中の実力者で、ジョージ・W・ブッシュだけでなく、父親である第41代大統領のジョージ・H・W・ブッシュの選挙戦も手伝いました。つまり「ブッシュ家お抱え」みたいな存在なんですね。

アメリカの選挙では、側近がどれぐらい候補に忠誠心があって、また候補本人がその側近に信頼を置いているかということが非常に大事なのです。ジョージ・W・ブッシュの二度の大統領選で、カール・ローブはネガティブキャンペーンのような「汚れ仕事」もすべて引き受けました。対抗馬で立った候補を蹴落とすために、大量の攻撃広告をうち、支持者には候補を中傷する電話をかけ、候補の過去の汚点をマスコミにリークしたりしました。

ローブは戦略家としての信任も実績もあったので、彼が必要だと言えば有権者データベース作りのような大がかりなプロジェクトにも、資金面でゴーサインが出た。ビッグデータを使った選挙は非常にお金がかかるので、大統領選クラスでないとなかなか難しいのです。

――具体的にはどこにお金がかかるのですか。

平林 先ほど申し上げた「データマイニング」にすごくお金がかかるんです。今はいろいろな業者がデータベースをもっているのでそれを買うなり借りるなりすればいいのですが、一番最初の段階ではデータを蓄積するところから始めなければなりません。

また足りないデータを補うための世論調査などの費用や、行動予測の精度を上げるために、何十人から何百人もの「データ・サイエンティスト」を使って、コンピューターでシミュレーションをする必要があります。

オバマ陣営の場合は、コンピューターの前でシミュレーションを組み上げるのが三度の飯より好きだという「行動科学オタク」のような人たちがたくさん集まっていました。

しかも12年の大統領選では、オバマ陣営はその作業をすべて自前のグループだけでやりました。当然すごい費用がかかります。「インハウス」(in house)というのですが、選挙本部の部屋でそういう人たちが一箇所にずらりと並んで作業をする。業者任せの方が費用的に安くすむけれど、一般の業者は複数の陣営とクライアント契約することも少なくないので、情報漏洩することを恐れたのでしょう。

また集めたデータは、特に投票や支持にかかわる場合、非常に高い頻度で更新していかなければ意味がありませんし、データの中に個人の連絡先が含まれていないと訴求もできません。

どんな特性を持った人がどんな行動に出やすいか、個人がアイデンティファイ(特定)できて、ある一定のカテゴリーに入る人は誰と誰で、その人たちはどこに住んでいて、それぞれのeメールアドレスはこうだ──ということまでわからないと、陣営もコンタクトの取りようがありません。とりわけ個人のeメールアドレスはしょっちゅう変わりますから、今までの情報に新しいものを加えて何度も更新する必要があるんです。

平林 ブッシュ陣営はそうやってビッグデータを駆使して有権者の見直しを進めました。ただ、大事なのは、ビッグデータは相手を「探す」手がかりになるだけで、探し出してその人にアプローチすることはできても、その相手を戦力化し、集団として組織化するところまではできないということです。 その点、カール・ローブがすごかったのは、そうした「組織化」の重要性をきちんと踏まえていたということだと思います。

――御著書では「カール・ローブは(略)新しいマーケティングの方向性を切り開いた。ひとつは、ビッグデータとマイクロターゲティング、もう一つはマルチレベルマーケティングと呼ばれる、『ねずみ講』に似た自己展開型草の根ネットワークの構築である」と書かれています。

平林 特にアメリカの政治ではそうなのですが、ターゲットとなる有権者を実際に集めて組織化し、政治的な力としてまとめ上げるところまで持っていかないと、カネや票にはつながらないのです。個人個人で個別撃破の説得をしていても間に合いません。だからこそ組織化が重要で、例えばノンポリっぽい人ばかりが集まったら、そこに活動家を配して彼らを政治に目覚めさせ、組織として機能させるためにどうすべきかを、ローブは常に考えました。

彼は、一つは教会、もう一つはマルチレベルネットワーキングという、いわゆる会社組織のような形を使って新しい草の根のネットワークを組み上げていった。そうすることで、点在している潜在的な支持者を「一つの力」にしていったのです。

マルチレベルネットワーキングというのは、いわゆる「マルチ商法」の形になります。つまり互いに競い合うようになるのです。そしてそれに対する報奨のようなものもやっぱりあって、「有権者を何人集めたらホワイトハウスにご招待」といった「ごほうび」が用意されている。アメリカではそれも一つのビジネスモデルですから、ローブはそれを積極的に推し進めました。

――そうしたブッシュ陣営のやり方から学び、ビッグデータを使った「マーケティング戦略」を進化させたのがオバマ陣営ということですか。

平林 その通りです。ただその前に、08年の大統領選に挑戦しようとするオバマには、同じ民主党内にヒラリー・クリントンという強敵がいて、まずは予備選でヒラリーに勝たなければならないということがありました。

そのためにもオバマは過去の常識を覆す必要に迫られていたのです。

それまでの選挙上の常識としては「この選挙区はこの候補のもの」といった暗黙の了解事項があったのですが、オバマはそれをのり超え、草の根をかき分けてでも新たな支持者を探し出さなければならなかった。

08年の時点で民主党のヒラリー陣営は過去の常識にとらわれていましたから、共和党が強い州には初めから自分でオフィスを作ろうとはしなかったわけです。でもオバマは、そんな常識にとらわれていたらそれこそヒラリーにすら勝てない。だからもう一切の常識を外して考え、芽がありそうなところには一からオフィスを作っていきました。

具体的には、党の有力者の支持が厚いヒラリーとの正面対決を避けるため、オバマ陣営は、ヒラリーの支持基盤がすでに出来上がっていた予備選挙州よりも党員集会を行う州を狙うとともに、共和党支持者が多くてヒラリーが資源を投入しない、ヒラリー陣営のレーダーに探知されにくい州や層を狙った「ステルス戦略」を実行しました。

こうした動きをさらに加速させた要因としては、08年当時は民主党の全国委員会委員長だったハワード・ディーンという人の存在がありました。

ディーンは、クリントン時代の8年間で瓦解寸前となった、地方組織や草の根組織の再構築こそが民主党復活の唯一の方法と考えて、全米50州の選挙区や居住区などを徹底的に見直す「50州戦略」を作り上げました。

オバマ陣営はディーンのこの取り組みにも注目して研究し、自分の選挙戦略に採り入れたのです。

――オバマ陣営のそうした新たな戦略は順調にいったのでしょうか。

平林 最初からスムーズというわけにはいかなかったと思います。何しろ共和党と民主党ではやはり支持層が違いますので、データの集め方一つとっても両者は違うからです。

対話集会で支持者と語り合う民主党のオバマ上院議員=2007年2月、アイオワ州

対話集会で支持者と語り合う民主党のオバマ上院議員=2007年2月、アイオワ州ブッシュの場合ですと、支持層の多くは白人で教会によく行くような人たちです。宗教右派もいますが、それだけではなく、敬虔で平均的な、ちょっと古いアメリカ人のイメージですね。白人層が中心ベースという認識があるので、その人たちが住まいを「移動する」といっても限りがある。

ところが民主党の場合は、どちらかというとマイノリティーが中心です。アメリカ全土でいうと、共和党が真ん中の中西部、それから南部は取り合いになっていますが、民主党は東海岸と西海岸に分かれているわけです。

東海岸と西海岸では世論調査家を始め、選挙産業に携わっている人たちがみんな違います。だからデータがどうしてもバラバラになってしまう。しかもマイノリティーで有権者登録すらしていない人も多い。その分、データの捕捉や更新が大変なのです。

そこでオバマ陣営は、まずは自分たちのデータを全部かき集めて一つにまとめた上で、「さあどんなデータが必要だろうか」ということを一から考え直し、新たに組み上げなければならなかったという事情がありました。

――でも、そうした全米的な見直しについては共和党の方も00年の大統領選直後から進め、民主党が取り組み始める何年も前から新たなデータベース作りを始めていたわけですね。にもかかわらず、オバマと民主党の方がなぜデータの使い方がうまく、徹底的な見直しができたのでしょうか?

平林 その疑問を考えてみると、違いはやはりオバマが「新しいアメリカ」を念頭に置いていたからではないかと思います。

逆にいうと、共和党はいつまでたっても「古いアメリカ」から抜け出ることができなかった。でも現実はヒスパニック層が急成長していて、人口比的にもアメリカ人のイメージは変わりつつあったのです。マイノリティー層の高学歴層も育っており、そういう人たちが「新しい南部」といわれるジョージア州とかノースカロライナ州などに入って選挙地図をどんどん塗り替えていきました。

「アメリカは変化している」という考えがオバマの念頭に強くあればこそ、「新しいデータを収集しなければ到底勝てない」という強い切迫感が生まれ、オバマをいっそうビッグデータに駆り立てたのではないかと思います。

平林 教会対応にしてもマルチレベルネットワーキングにしても、カール・ローブやブッシュ陣営がやったことはどちらかといえば「地上中心」でした。

オバマは「それをオンラインでできないか?」と考えたのです。

実際、民主党支持層も東海岸と西海岸に分かれていますから「教会に集めて一緒に」というわけにはいかない。

では、どうするか。オバマは自身がシカゴでコミュニティー・オーガナイザーをしていた経験も踏まえながら「ローブが手がけたあのうまいやり方をオンラインでやろう」と考え、有権者一人ひとりを狙い撃ちにするマイクロターゲティングや、マルチレベルネットワーキングの手法をバージョンアップさせていったわけです。

オバマ陣営とブッシュ陣営の違いはほかにもあります。

教会とかマルチレベルネットワーキングを使うやり方というのは、いずれもお互いにある程度人脈がすでにできている者同士をつなげるということだった。マルチ商法だって、まずは自分の知り合いに声をかけるじゃないですか。だから結局、ブッシュの場合は「知り合い同士のネットワーク」作りレベルにとどまっていたのです。

平林 ところがオバマは、お互いに知り合いとは限らない人たちのデータをまずはオンライン上で探し、「この人は今までにどれぐらい政治活動をしてきたか」「投票しているか」「献金しているか」という「アクションポイント」と呼ばれる項目に注目した上で、一定の人たちをすべて抽出し、政治的な意識や活動水準が同じ位の人たちをオンライン上でたばね、「君たち、まとまらない?」と勧誘したのです。

民主党のオバマ候補(手前)の最後の集会には大勢の支持者が詰めかけた=2008年11月、バージニア州マナサス

民主党のオバマ候補(手前)の最後の集会には大勢の支持者が詰めかけた=2008年11月、バージニア州マナサス私自身、オバマ陣営から何度かメールをもらいましたよ。地域でも「オフ会」みたいな集まりができていましたが、ただそれだけではなく、活動レベルや意識レベルがもっと高い人たちに対しては「君はオハイオ州にいるけど、ジョージア州にも君みたいにいろいろなことをやっている人がいるよ。コンタクトしてみる?」といって誘導しました。そんな感じで、空間的には離れているけれど意識や活動が似通った人たちをネット上で一つのグループに集めていった。すると、彼らはお互いに競争し合うようになるのです。

――まさにマルチ商法ですね。

平林 「コミケ」(コミック・マーケット)の中の競争みたいなもので、「お前がそれだけやったのなら、よし、おれも」みたいな感じなんですね。それでどんどんポイントを稼いで自分のスコアを上げていく。

全米中に散らばっている「政治オタク」だった若者が、オンラインによるオバマの呼びかけを通して仲間になり、互いに競い合って活動家に育ち、「核」になって地域のオフィスも作り、やがては資金集めや票集めの元締め、あるいは個別訪問のリーダーになり、たくさんのボランティアやカネ、票を集めていくわけですから、それはやっぱりすごいことでした。

平林 「誰をつかまえなければいけないか」「誰を説得しなければいけないか」。その目的意識がすごくはっきりしているのがオバマのすごさです。

つまりビッグデータというのは、「データを何に使うのか?」という明確な目的意識を持っているかどうかがカギで、そうでなければお金ばかりかかって何の意味もないということがポイントなのです。

その点、オバマは巨額のお金も使いましたが、目的が非常にはっきりしていて、しかも得票につなげる正確なモデルを組み上げ、それに命を懸けるような人たちをまわりにいっぱい集めた、という点が画期的だったと思います。 例えばオバマ陣営は、「戦略州」のすべての有権者を対象に、四つの数字を割り当てました。

第1はオバマの「支持度」で、0点から100点まですべてスコア化しました。第2は選挙に行ってオバマに実際に投票する可能性。実際、オバマに投票しない有権者にいくら動員をかけても仕方がないわけですから。

この二つに、12年の大統領選ではさらに二つの数字が追加されました。

一つは、オバマを支持はしているけれどオバマに投票するとは限らない人たち。英語でいうと「Inconsistent」と表現するのですが、要するに投票行動に矛盾があって揺れている人たち、何か働きかけたら選挙に行きそうな人たちのスコア化ですね。

さらには説得をしたらオバマへの支持が絶対に強まる層もスコア化しました。

その結果、「この人の説得可能度は何点で、どんなメッセージを送ればそのスコアが上がるか」ということをすべてシミュレーションすることができたというわけです。

――オバマ陣営は、ロムニー陣営もそうですが、選挙戦でテレビも「活用」しました。

平林 アメリカではケーブルテレビが多チャンネル化で浸透しています。都市型ケーブルテレビですね。

ケーブルテレビの会社は、各家庭にケーブルテレビ用のデジタル対応チューナーを設置するのですが、その段階で相手に例えば家族構成などを聞くのです。

そうした細かいデータを蓄積するとともに、「何時にどのチャンネルを誰が見ているか」をデータ化していて商売の種にしています。

オバマ陣営はそのデータに注目し、「民主党を支持してはいるけれども迷っている」といった特性の人たちをビッグデータで調べた上で、その有権者特性に合った人たちをケーブルテレビ視聴情報で探し出しました。

その人たちは多くの場合フルタイムの仕事についているから、夜の7時までは帰ってこない。となると、テレビを見るのはディナーが終わった午後9時から11時までと推定し、午後9時の直前か、午後11時の直後に電話をかけるのです。テレビを見ている時に電話をすると切られてしまうからです。

ことほどさように効率的に資源を使い切ったという感じがあって、やはりオバマはただ者ではない。ちょっと小憎らしいぐらいただ者ではないと私は思います。

――誰に投票するかを決めていない人たち、いわゆる「態度未決定者」の中で「説得可能な層」はわずかに5%ぐらいだそうですね。

平林 そうなんです。オバマ陣営はその層を重視し、ビッグデータやソーシャルメディアを使ってそうした未決定者を探し出して一人ひとりを説得していきました。

具体的には、まずはその人が本当に説得可能な層に属しているかどうかを確認するため、世論調査のような感じで相手に電話をかけます。やり方としては、用意していた必要項目についてまずは聞き、「この相手はたしかに説得可能な層だ」とわかった時点で、今度は政策を始めとする別のいくつかのメッセージを実験的に話すのです。

そして最初の時点では「自分はオバマ支持なんだけど今回投票するかどうかはわからない」と言っていた人が、政策の質問をした後にオバマへの支持がどれぐらい「強まったか」、あるいは「弱まったか」、または「変わらなかったか」をチェックしました。

その結果、もし「強まった」のであれば説得のメッセージは「有効」だったということになり、その有権者の特徴とセットでコンピューターにデータを記憶させるやり方をとりました。

当選を決めたオバマ候補は、家族と共に手を振って支持者に応えた=2008年11月、シカゴ

当選を決めたオバマ候補は、家族と共に手を振って支持者に応えた=2008年11月、シカゴ平林 クリントンも世論調査を使いましたし、ブッシュも有権者データを更新するということをしましたが、ここまで徹底的に「人間の行動を予測する」ことにこだわったのはオバマが初めてだったと思います。

それはそういう時代だったというだけでなく、やはりオバマ自身の人生の歩き方とどこかで重なっている部分があるのではないかと感じます。

オバマは非常に慎重で、かつ冷静な人間ですから、いつも準備を怠らず、チャンスがきたらさっと攻め上がる。バスケットをやっていた時もそういう攻め方をしていたそうですが……。

オバマが黒人として生きていく上で、最初から「異議申し立て人」になってしまうと、白人はみんな怖がって近づかなくなる。だから「僕は決して怒れる黒人にはならない」といって、白人にとって「脅威にならない黒人像」を演じ続けてきた。それでも相手を説得しなければならない時が来ると、猛然と理詰めで説得する。オバマのそういう生き方が彼の選挙戦にも影響しているように私には思えてなりません。

――そこまでビッグデータを駆使して大統領選を勝ち抜いたオバマに対し、アメリカのメディアはどんな対応をとってきたのでしょうか。

平林 元米中央情報局(CIA)職員のスノーデンによって、米国家安全保障局(NSA)が政治家や個人の通話記録を極秘に大量収集していた実態が暴露されましたね。

あの事件にも象徴的に現れているように、オバマは基本的に「秘密主義」なのです。情報を集めて分析するのが趣味だし、しかもそれをどう使っているのか、集めたデータを今後どうするのかといった肝心な点についてオバマは何も語りません。

そんな中、全米最大の調査報道NPOである「プロパブリカ」(PROPUBLICA)は、ビッグデータを駆使したオバマの選挙戦略に関して私たちが知っていること、知らないこと、今までわかったことなどをオンラインで定期的にリポートしてきました。

例えば12年3月27日には、「オバマの巨大な有権者データベースについて私たちの知らない三つのこと」というタイトルの記事を出しました。

「オバマ大統領の再選キャンペーンは、潜在的な支持者情報に関する巨大なデータベースを構築しつつあると伝えられる」という書き出しで、オバマ陣営側が何も語らないので詳細はよくわからないが、オバマが集めた巨大な情報は今後どうなるのか、どう使われるのか、もし個人が「いやだ」といったら自分の情報を消してもらえるのか、など様々な点が不透明になっていると伝えています。

――ビッグデータの問題をめぐっては、政治家側がすべてのデータを握っていて、その使い方も政治家に委ねられており、有権者はコントロールされるばかりという点は非常に深刻です。

平林 いわゆるブラックボックスとなる部分が大きいなど「データをめぐる民主主義」は非常にアンバランスです。有権者が政治の側に一方的にやられっぱなしになっているままでいいとは私も思いません。

巨額のお金を使ってデータを集めたプロセスや構築されたデータベース、または集積された膨大な個人データのあり方そのものについて、政治家だけがその実態を知っていて国民が知らないのは非常にまずい。

例えば2年後、あるいは4年後、オバマが集めた巨大なデータベースを誰が使うのかも皆目わからないのですからね。

この問題はアメリカだけでなく、ビッグデータの手法が仮に導入可能になったとすれば、将来的には日本でも同様に起こり得るでしょう。特に日本の場合は情報公開法がまともに機能しているとはいいがたい状況ですから、事態はより深刻になるのではないかと危惧しています。

平林 アメリカのジャーナリストの中でこの問題に最も詳しい一人に、ボストン・グローブ紙で記者をやっていたサーシャ・アイゼンバーグというジャーナリストがいます。

演説するオバマ氏と歓声で応える聴衆=2012年11月、オハイオ州

演説するオバマ氏と歓声で応える聴衆=2012年11月、オハイオ州サーシャは、最新のデータ科学が今の選挙でどう使われているのかについて『THE VICTORY LAB』という分厚い本を書きました。 この本を読むと、オバマのビッグデータ選挙がけっこう好意的に書かれていて意外でしたし、驚きました。

サーシャがこの本で言っているのは、要約するとこういうことです。

いわゆる「テレビ政治」といわれた時代は、実はヒトの顔が見えない選挙キャンペーンをやっていたが、それがデータの時代になると、オバマがやったように一人ひとりに合わせて作り変えた「カスタマイズされた情報」で有権者にアプローチするようになったので、その意味で選挙が「よりヒューマンになった」といえるというのです。

「データを使う」というと、何かすごく非人間的なことのように思えるかもしれないが、むしろ「テレビ政治」の方が非人間的で、ただもう電波を使った空中戦だった。それに対し、データを使って有権者にアプローチするということは、選挙のボランティアが有権者一人ひとりに向き合うことでもあり、そうしたパーソナルな出会いの結果として選挙キャンペーンでは「人間の温かみ」とか「人間同士のふれあい」みたいなもの、つまりは「ヒューマンタッチ」が重視されるようになったとサーシャは指摘しています。

――ビッグデータを駆使した上で、ターゲットとしての有権者を政治家にとって「有意義なデータ」に仕立てあげる一連の行為が「ヒューマンだ」という評価は何だか腑に落ちない気がします。

平林 他方、ニューヨーク・タイムズなどは、データに特化することで選挙戦が「有権者をいかに説得するか」ということだけになってしまっていると指摘しつつ、民主主義はそんな説得だけではないだろう、結果としてオバマのやり方は様々なプロセスを非常に貧弱なものにしていると書いていて、私はこの見方の方がむしろ一般的だと思います。

平林 アメリカのジャーナリストは大統領選になると、最初から各陣営の内部に深く入って密着します。その度合いも半端ではなくて、候補の戦略会議まで全部入ってしまう。

そしてその過程ですべてを見た上で、選挙が終わったあとに本を書いたり、本格的な記事を書いたりします。1回や2回の記事を書くためにそれをするのではなく、「誰かが見て記録をしなければすべては闇から闇に葬られてしまう。自分がしっかり見ておかないと後世に歴史的資料が残らないぞ」という、ジャーナリストとしての使命感で大統領選を追いかけている。そこがすごいと私は思います。

また歴史的資料を残すということでいえば、アメリカでは大統領になった後、大統領の言葉の一語一句はすべて「大統領図書館」に公文書として保管されることが法律で決められているのです。政権の戦略会議でどんなメモを使ったか、どんな世論調査をやってどんなリポートが業者から来たか、何から何までがすべてその図書館に一級の歴史資料として残っています。

――大統領選の過程もそうなのですか?

平林 いえ、「大統領になったその日から」なんですね。そこがポイントです。私も大統領図書館に何度も行きましたが、政権の一挙一投足に至るまで詳細な一次資料が保存されていますが、選挙中に何をしたかはわからない。

後世に歴史的資料を残す覚悟で大統領選に密着するジャーナリストと、一級の歴史資料を残す大統領図書館と。その双方が本当にすごいと感じます。

平林 今のデータジャーナリズムについていうと、データを使うだけでなく、むしろそのデータを使って「見せる」ことも大事じゃないですか。読者や視聴者は、自分たちが必要なデータは自分で検索できる時代なのですから、プロのジャーナリストがデータを使って記事を書けばいいということにはならないわけで、それこそ、そこに「プラスアルファ」が求められている。ジャーナリズムの課題としては、それにどう応えていくかということが一つ。

ただ同時に、「データだけではわからないもの」もやっぱりあって、それは歴史なんですね。

一つの事象のバックグラウンドや、今のこの状態を作った要因は何か、いつどこでどんなキーパーソンが動いた結果こうなったのかなどといったことを明らかにするためには深い取材が必要です。

もちろんデータを詳しく見るとある程度のことはわかるけれど、でもデータだけですべてがわかるとは限らない。

掘り下げた深い取材に基づいて「歴史をきちんと書ける」人こそが「ビッグデータ時代のジャーナリスト」なのだろうと私は考えていて、その意味で、データジャーナリズムの時代に「報道者のハードルは上がった」と思うのです。記者の方にもいっそうの心構えが必要になってきたということではないでしょうか。

「今はデータジャーナリズムの時代だ」ということになると、データが早く手に入るようになればなるほど、編集や加工、出版のサイクルもますます早まってくるように思います。

そういうふうに何でも早まってくると、ジャーナリストがものを考える余裕やじっくり勉強する時間がなくなるのではないか。でも、もしそうなったら、それは人々が報道に対して本当に求めていることに応えられないジャーナリストを大量に生産することにつながるような気がします。

「データが大事だ」といわれる時代だからこそ、政治なら政治、社会問題なら社会問題に時間をかけてじっくり取り組んだ上で、「このデータは私たちにとってどういう意味を持っているのか?」ということを的確に分析してくれるジャーナリストが求められているのだと思います。

アメリカのジャーナリズムを見れば、例えばホワイトハウスを何十年も担当している記者がいるわけです。それなのに日本ではニュースのサイクルがどんどん早まっていて、それに伴って例えば人事異動のサイクルも早まっていくとしたら、歴史的なことを勉強して蓄積していく時間がそれだけなくなってしまうのですから、それはもうジャーナリズムの自殺ではないか。私はそう考えています。

――ところで、日本の選挙にもビッグデータを駆使する手法が本格的に導入されるような時代は来るでしょうか。

平林 日本の政治報道は相変わらず「無党派層」と書いていて、有権者が十把一絡げに扱われています。報道各社が「出口調査」をするといっても、人口統計学的な属性、性別や職業、学歴、家族構成などいわゆるデモグラフィック的なことしか見ないでしょう。

デモグラフィックも大事だけれど、それでは何も決まらないからビッグデータへの必要性が高まったのです。年齢や人種の違いだけで投票行動がわかれば誰も苦労しません。そうではなくて、同じように若い人で、都市部に住んでいても「なんでこんなに投票行動が違うの?」と疑問に思った時に、アメリカでは一人ひとりの価値観や行動特性を始めとする様々なビッグデータを集めるようになったわけです。

そのことと比べれば、一言でいえば日本の政治家も報道する人たちも、「揺れ動く有権者の本当のカオ」がわかっていないと思います。

でも「もっと有権者のカオを見ましょうよ」と政治家に言うと、先生たちはみんな「いや、うちは後援会でみてますから」なんて答えるんですよ。

――オバマが手がけたような選挙は日本では到底無理ということですか。

平林 ビッグデータの活用はビジネスの世界がやり始めているのですから、様々な有権者のデータが集まれば政治の世界でもできないことはないのかもしれません。ただし、ビジネスの場合はそれをやる目的がはっきりしています。つまりデータを集めるコストに対して結果としてのパフォーマンスがあるからできているのであって……。

政治の場合はそもそも「自分がメッセージを届けたいターゲットは誰なのか?」というイメージすらはっきりしていないのに、データだけむやみに集めても無理ではないかと私は思います。

例えば自民党と民主党が、「東京のこの選挙区に住んでいる有権者の300人を獲得できないと我が党は負ける」とお互い真剣になったとします。

その際、その300人のうち説得可能な層はどんな人なのかという特徴をきちんと把握した上で、それを三つぐらいのグループに分けて「A、B、C、3種類のメッセージのうちどれが一番有効なのか」を知りたいと政治家が本当に思うようになった時に初めて、データの意味が出てくるのです。

でも、日本の政治家はそんなことまで知りたいとは誰も思わないでしょう? だから日本の選挙に本格的なビッグデータは必要ないというか、今の政治のレベルでは、たとえやったとしても「無用の長物」で終わるということではないでしょうか。(文中敬称略)

◇

平林紀子(ひらばやし・のりこ)

埼玉大学教養学部教授。

1992年に早稲田大学大学院政治学研究科博士後期課程修了。99年から2001年まで、ハーバード大学ケネディ行政大学院及びジョージ・ワシントン大学政治経営大学院で客員研究員を務めた。埼玉大学教養学部助教授を経て02年から現職。専門は政治コミュニケーション及び現代アメリカ政治。 著書に『マーケティング・デモクラシー 世論と向き合う現代米国政治の戦略技術』(春風社)、共著に『個人と社会のインターフェイス——メディア空間の生成と変容』(新曜社)など。

..................................................

※本論考は朝日新聞の専門誌『Journalism』7月号から収録しています。同号の特集は「ビッグデータ時代の報道とは何か」です

有料会員の方はログインページに進み、朝日新聞デジタルのIDとパスワードでログインしてください

一部の記事は有料会員以外の方もログインせずに全文を閲覧できます。

ご利用方法はアーカイブトップでご確認ください

朝日新聞デジタルの言論サイトRe:Ron(リロン)もご覧ください