ディープラーニング(深層学習)でブラックボックス化が進む

2018年10月30日

ディープラーニング(深層学習)によるAIの進化に、注目が集まっている。期待と共に漠然とした不安も大きいようだ。AIの脅威は本当なのか。

汎用AIの能力が人間を大きく超えることで社会が変容するシンギュラリティ(技術的特異点)を迎えるのは2045年。当初はそのように言われた(R. カーツワイル)。しかし特定の分野によっては、シンギュラリティなんてとっくに超えられている。将棋、囲碁がその例だ。将棋の「電王戦」は(プロとソフトが対抗する形式としては)機械側の圧勝で終わった(2015年3〜4月)。グーグルが開発した「アルファ碁」は、世界でもトップレベルのイ・セドル九段(2016年3月)、世界最強とうたわれた柯潔(かけつ)九段(2017年5月)を連覇した。技術的には深層学習に、モンテカルロ探索や強化学習と呼ばれる手法を組み合わせて成功したという。

ポイントは、AI進化の原理そのものが変わったところにある。将棋・囲碁の強豪ソフトは(ヒトの専門家から知識を学ぶ)エキスパートシステムという古典的な方法を捨てた。代わりにソフト同士が1日に1万局も対局し、その経験から学ぶ方法を採って、一気に進化した。結果、「ボナンザ新手」(ボナンザは将棋の最強ソフト)と呼ばれるような、プロ棋士が思いもつかない創造的な指し手を編み出すに至ったのだ。

水は深くなるほど不透明になり、底が見えなくなる。同じように機械の学習が進むほど、その中身は人には見えにくくなる。以下この点に特化して検証したい。

シンギュラリティを超えたAIのふるまいは、人には理解できない。この点を象徴的に示すケースとして、「敵対的事例(Adversarial Example)」と呼ばれるものがある(グーグルの研究グループの成果;Goodfellow, et al., ICLR, 2015)。

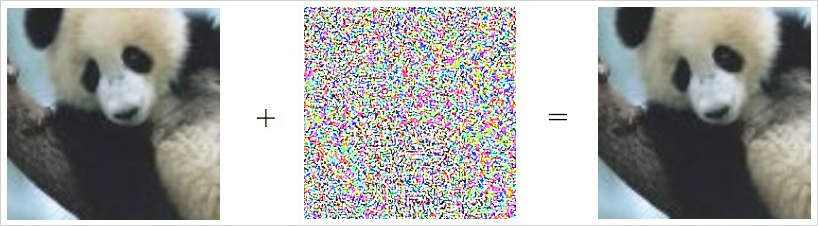

下図で、左の画像は誰が見てもパンダだ。深層学習したあるAIも、もちろんパンダと分類した( 確信度は60%弱)。これに特別なノイズ(中央の画像)を加えたのが、右の画像だ。見た目ほとんど元の画像と変わらず、誰でも相変わらず「パンダ」と答えるだろう。ところが先のAIはこれを「テナガザル(gibbon)」と見誤ってしまう、しかも99%以上の確信を持って!

左の画像に中央のノイズを加えて右の画像にすると、AIはこれを99%以上の確信度で「テナガザル」と認識する。このような敵対的事例から、AIが人とは全然違う方法で認識していることがわかる。Goodfellow, et al., ICLR ‘15

左の画像に中央のノイズを加えて右の画像にすると、AIはこれを99%以上の確信度で「テナガザル」と認識する。このような敵対的事例から、AIが人とは全然違う方法で認識していることがわかる。Goodfellow, et al., ICLR ‘15はあ?という読者の声が聞こえそうだ。中央のノイズの画像も、特に何か意味があるようには見えない。それほどに、機械の振る舞いは私たち人間の想像を超えている。

タネを明かすと、ここにはふたつのAIが関わっている。まず普通に深層学習して、写真画像を分類するAI (便宜上「分類屋」と呼ぼう:今インターネット業界で活躍し始めたのは、この種だ)。これに対してその作動を分析し、わざと間違いやすい画像事例を生成する別のAIがいる(勝手に「裏かき屋」と呼ぶことにする)。ノイズを加えて右の画像を作り出したのは、この「裏かき屋」だ。

ごく直感的にいうと、元の分類屋AIは画像の局所的(部分的)な特徴(たとえば白黒のコントラストがあるとか、斜めに傾いた線がある、など)とその組み合わせから、様々なパンダ画像の共通点を絞り出している。一方「裏かき屋」AIは、こうした局所的な手がかりをことごとく裏切るように計算されたノイズ(図の中の画像)を加えたというわけだ。

人工知能「ワトソン」が分析した注目ワードを表示するディスプレー=日本IBMの受付ロビー、2018年1月

人工知能「ワトソン」が分析した注目ワードを表示するディスプレー=日本IBMの受付ロビー、2018年1月敵対的事例をここで紹介したのは、AIのやっていることを人が理解できない=ブラックボックス化の、もっとも迫力ある例だと思ったからだ。ここからふたつのことがわかる。まず第一に、AIは(多くの場合)人とは根本的に異なったやり方で、課題を解決する。そして第二にAIのその解き方が(多くの場合)人には理解できない。

この2点はAI一般に共通だが、深層学習で特にはっきりしてくる。だがまさにこの2点の事情によって、想像を超えた、突拍子もないエラーにつながる懸念がある。

この「突拍子もない」を、少し掘り下げておく価値があるかもしれない。実はこの懸念は「フレーム問題」とも関連している。

有料会員の方はログインページに進み、デジタル版のIDとパスワードでログインしてください

一部の記事は有料会員以外の方もログインせずに全文を閲覧できます。

ご利用方法はアーカイブトップでご確認ください

朝日新聞社の言論サイトRe:Ron(リロン)もご覧ください