自動運転が突きつける倫理のジレンマ

2016年11月17日

自動運転の車が街中(まちなか)を走り回る時代が、目前に近づいている。実際に各国で試験運転が行われているのはもとより、シンガポールではすでに自動運転のタクシーが公道で試運転しているという。そんな中、米国における自動運転車テスラの相次ぐ事故がニュースになった(「WIRED」7月14日;「現代ビジネス」7月17日;「carview!」7月20日など)。最新報道では「対策として、障害物などを検知する能力を高めた新たなソフトウェアを提供」とのことだ(朝日新聞デジタル、9月12日)。

しかし「危険の(カメラ、レーダーによる)自動検出に不備があった」という点以外に、もっと本質的な問題が実は提起されている。それを詳述する前に、まずは「自動運転」について理解を深めよう。

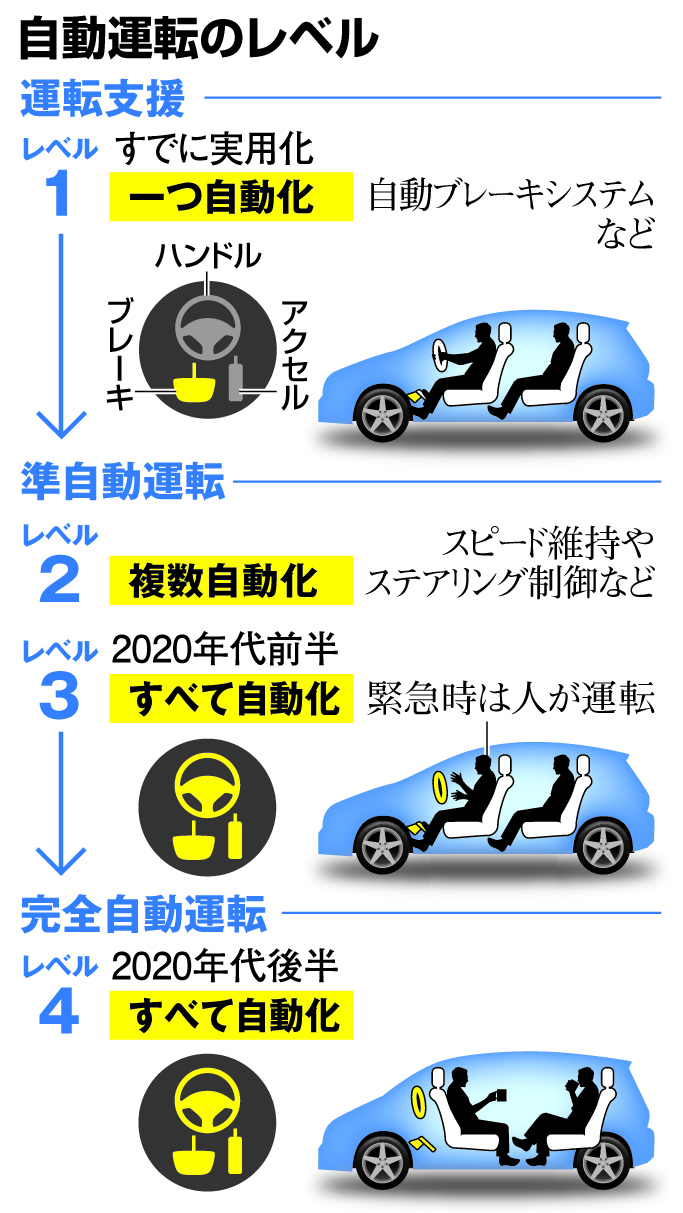

20年後には4台に1台が自動運転車なるという予想がある。といってももちろん「自動運転」の定義による訳だ。自動運転は以下の4つのステージに大別できるという(土井美和子、原隆浩『 ICT未来予想図: 自動運転,知能化都市,ロボット実装に向けて (共立スマートセレクション) 』;NHKスペシャル「自動運転革命」9月17日放送、他)。

現在はレベル2〜3で世界の自動車メーカーが開発を競っている。グーグルなどIT系も参入して、技術戦略のせめぎ合いとなっている。たとえばグーグルは自動運転車を作って売るのではなく、ビッグデータを武器に自動運転のプロバイダーを目指している(NHK、前出)。つまり自動車会社のパートナーになって世界中の車に自社の自動運転装置ソフトを取り付け、走らせる。そこから「ただで」大量のデータを収集し、次につなげる。ビッグデータがビッグデータを呼び込む算段だ。

そんな中「サイエンス」誌に、「自動運転の倫理」をテーマとするタイムリーな論文が掲載された (Bonnefonら、Science、2016)。そもそも倫理学関係の論文がこの科学誌に載ること自体が稀で、それだけにインパクトが大きい。自動運転でなぜ倫理の問題が提起されるのだろう?

もともと運転自動化で90%の事故は防げると言われている(少なくともテスラはそのように主張している)。しかし残りの10%はどうなるのか。身内が事故死した時、「機械やアルゴリズムのミスだった 」で遺族は納得できるだろうか。その上もっと厄介なことに、「人の命を助けるには誰か他の人を犠牲にせざるを得ない」ケースもままある。

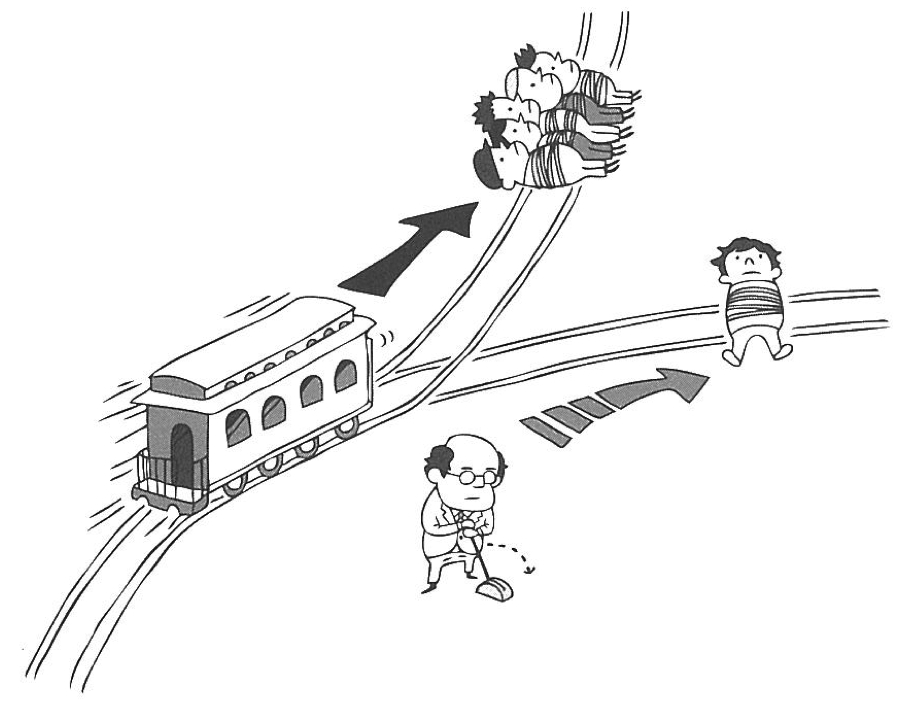

デイヴィッド エドモンズ著『太った男を殺しますか?』に示されたトロッコ問題のイラスト

デイヴィッド エドモンズ著『太った男を殺しますか?』に示されたトロッコ問題のイラスト線路を走っているトロッコが制御不能になった。このままでは、線路上で作業中の5人がトロッコに轢き殺されてしまう。あなたは線路の分岐器の近くにいて、トロッコの進路を切り替えれば5人は助かる。だが困ったことに、切り替えた先にも1人の作業員がいる。5人を助けるために1人を犠牲にしていいのか? それとも運命として、そのまま見過ごすべきなのか?

有料会員の方はログインページに進み、朝日新聞デジタルのIDとパスワードでログインしてください

一部の記事は有料会員以外の方もログインせずに全文を閲覧できます。

ご利用方法はアーカイブトップでご確認ください

朝日新聞デジタルの言論サイトRe:Ron(リロン)もご覧ください